Gastbeitrag von Victoria Graul

KI kann „History facts“ mittlerweile in Sekundenschnelle und in großer Stückzahl verfälschen. Gerade emotional aufgeladene Inhalte führen da besonders leicht in die Irre. Wir zeigen, was es für History-Fakes gibt, welche Strategien dahinter stecken und was hilft, die Flut von Fake-History-KI-Inhalten zu bremsen.

Profit mit KI-Fakes

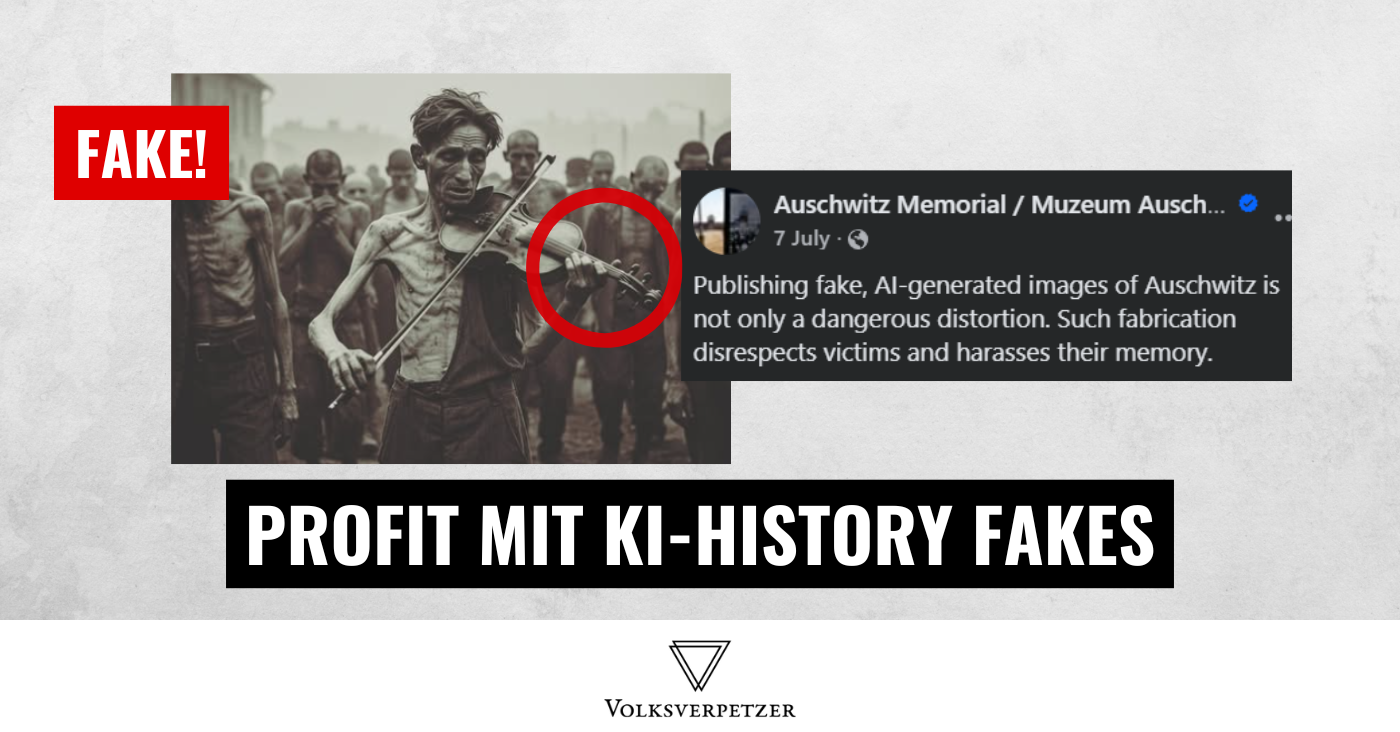

Eine Reihe von KI-generierten Bildern von Holocaust-Opfern hat im Sommer dieses Jahres Aufsehen erregt. Ein viel diskutiertes Bild in Sepia-Optik zeigt einen abgemagerten Häftling mit Geige inmitten einer Menschenmasse. Die Kommentarspalte ist übersät mit Anteilnahme und Mahnrufen vor Genozid. Wer genau hinschaut beziehungsweise heranzoomt, dem fallen einige optische Unstimmigkeiten auf. So etwa scheinen die Finger des Musikers an der linken Hand merkwürdig abgebogen und unterschiedlich groß, auch die eines Häftlings im Hintergrund wirken deformiert. Die äußere vierte Saite der Geige verschwindet im Bereich des Schwanzstücks. Außerdem erscheint es merkwürdig, dass der Musiker ein Oberteil trägt, das nur aus einer linken Hälfte besteht. Das trifft auch bei einer weiteren Person im Hintergrund zu. Darüber hinaus fragt man sich, warum alle Häftlinge außer der Geiger (und eine weitere Person mit Mütze) rasierte Köpfe haben.

In dem Posting dazu wird behauptet, dass der Mann mit Geige zum Gefangenen-Orchester im Konzentrationslager Auschwitz gehörte und den Gang zur Gaskammer musikalisch begleiten musste. Auch diese Geschichte ist frei erfunden, wie das Geschichtsmuseum Auschwitz Memorial auf Social Media mitteilte. Demnach gab es Häftlingsorchester im Lager, aber sie spielten in der Regel für den Marsch zur Arbeit und bei der Rückkehr, nicht als Begleitung zur Hinrichtung. Eine Recherche der BBC deckte wenige Wochen später sogar auf, dass hinter solchen KI-Beiträgen ein internationales Netzwerk von Fake-News-Produzenten aus Pakistan steckt, die damit auf Facebook Geld verdient haben.

Wie KI zur Manipulation von Geschichte beiträgt

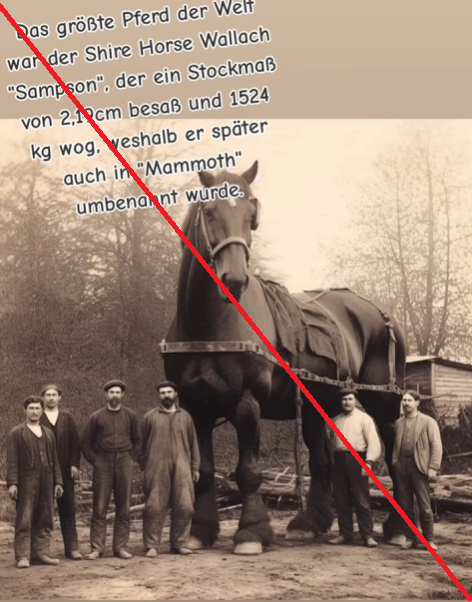

Vielleicht kennst du auch den Hoax über das angeblich größte Pferd der Welt oder die falsche Geschichte über die Weltkriegs-Krankenschwester, die die Namen der Gefallenen in der Normandie aufschreibt. Solche Retorten-Bilder verdeutlichen, wie der gegenwärtige Fortschritt rund um Künstliche Intelligenz gezielt zur Verzerrung von Geschichte eingesetzt wird. Natürlich waren Fotos nie frei davon, dass mit ihnen historische Begebenheiten verfälscht oder inszeniert wurden. Klassische Beispiele sind die Retuschen in der Sowjetunion unter dem Diktatur Josef Stalins und das vermeintliche Foto vom Reichstagsbrand 1933, das auf einer Aufnahme aus einem DDR-Film basiert.

Früher kostete es eher viel Zeit, Fälschungen zu erstellen, um damit historische Narrative zu beeinflussen. Auch war es schwieriger, diese über die traditionellen Medien und Bildungseinrichtungen einzuschleusen. Diese Lücke füllt nun generative KI, die für Nutzende oftmals kaum etwas kostet, ohne großes Vorwissen immer schneller und bessere Ergebnisse erzeugt. So entstehen beispielsweise sekundenschnell und für die weltweite Verbreitung merkwürdig abgewandelte Versionen von Fotos der Zeitzeugenschaft, die mit den Original-Bildunterschriften arbeiten. KI-generierte Portraitbilder vermischt mit nachprüfbaren Biografien, oder aus dem Kontext gerissene Inhalte, bei denen das KI-Label entfernt wurde – die ganze Bandbreite an Typen und Formen von Desinformation kommt zum Tragen.

Der Trend hin zur Massenproduktion von Bildern, Videos und Texten mit KI wird mittlerweile als „AI Slop“ (zu deutsch: „KI-Abfall“) bezeichnet. Dabei dient KI nicht nur dazu, Desinformation zu verbreiten, sondern auch, um schlichtweg unterhaltende Inhalte ins Netz zu spülen. Pseudowissenschaftliche Youtube-Geschichtskanäle wie „Sleepless Historian“ und „The Snoozetorian“ sind beispielsweise so engagementoptimiert, dass fehlerhafte Darstellungen wie gefälschte Belege oder falsche Zitate bekannter Persönlichkeiten in Kauf genommen werden. Das zahlt in das typische Geschäftsmodell der Plattformen ein. Zugleich profitieren AI-Slop-Produzenten von den Monetarisierungsprogrammen, die Meta, Alphabet und Co. anbieten, um ihr Geschäftsmodell am Laufen zu halten.

Was hilft, die Flut von Fake-History-KI-Inhalten zu bremsen

Jede einzelne Interaktion – ob Teilen, Liken oder Kommentieren – kann die Reichweite derartiger Fakes verstärken oder eindämmen. Daher haben wir für dich ein paar Tipps zusammengetragen, wenn du auf History-Inhalte stößt:

- Setz deine Quellencheck-Fähigkeiten ein: Verlässliche Quellen sind etwa studierte Historiker oder namhafte Institutionen wie Museen oder Gedenkstätten, die ihre Informationen mit belegbaren Fakten untermauern und generell transparent mit Wissenslücken sind.

- Verabschiede dich von gängigen Plausibilitätskriterien: Optische Merkmale wie Unschärfe, Sepia-Optik, Filmkorn oder Kratzer sind längst keine verlässlichen Qualitätskriterien mehr für historisches Archivmaterial.

- Hinweise auf KI prüfen: Das bedarf Übung sowie eine gute Bildschirm-Auflösung, aber achte auf Details, die KI beim heutigen technologischen Stand noch entlarven lassen. Dazu zählen logische und physikalische Fehler wie deformierte Körperteile, verformte Buchstaben sowie Wörter, die Frage, ob sich die gezeigten Personen dem Anlass entsprechend natürlich verhalten, Schattenform, blecherne Stimmen, und – explizit im Video – Dinge, die plötzlich auftauchen oder verschwinden. Ein weiteres Indiz ist die Häufigkeit von geposteten Beiträgen auf dem zu untersuchenden Profil. In der Regel ist die Recherche an einem komplexen Thema sowie dessen mediale Aufbereitung so umfangreich, dass es bis zur Veröffentlichung auch seine Zeit benötigt.

- In den Kontext einordnen: Beachte, dass die Fotografie erst um 1826 und der Film erst um 1888 erfunden wurden. Die Geburtsstunde der Tonaufzeichnung liegt um 1860.

- Bilderrückwärtssuche starten: Halte dich an OSINT-Tools wie TinEye, Google Bilder und Yandex und überprüfe, ob ein Bild oder ein Video schon einmal anderswo verwendet wurde.

- Sensibilisiere dein Umfeld: Warne Menschen wie Kinder und Senioren vor minderwertigen KI-Inhalten, die mit der Technologie kaum Berührungspunkte haben. Sprich gezielt Menschen aus deinem Netzwerk an, die so etwas teilen.

- AI-Slop-Inhalte melden: Nutze die Möglichkeiten der Plattformen, problematische Inhalte zu melden. Wende dich auch an Gruppen-Admins bei zum Beispiel WhatsApp-Gruppen oder Facebook-Seiten.

Verfälschen diese Fake-„History Facts“ unser Geschichtsbewusstsein?

Inwiefern solche AI-Slops langfristig unser Geschichtsbewusstsein prägen, ist noch nicht abzusehen. Ebenso so wenig, wie sehr sich das Vertrauen der Menschen in Bilder, Videos und Tonaufnahmen als verlässliche Grundlage für die Geschichtsforschung ändern wird. Allerdings lassen sich bereits Schlüsse aus einer Zeit ziehen, in der AI-Slops noch keine Rolle spielten. So zeigen die Ergebnisse der aktuellen „Memo-Studien“ zur deutschen Erinnerungskultur, dass sich nicht nur Verzerrungen und Lücken im historischen Wissen auftun (– lediglich etwa ein Drittel der rund 3000 Befragten konnte den Begriff „Euthanasie“ einordnen). Im Vergleich zu vorherigen Memo-Befragungen haben auch Verschwörungsglauben und antisemitische Einstellungen zugenommen. Daher erscheint es auch plausibel, dass böswillige Akteure gerade KI-Fakes zum Holocaust und zum Zweiten Weltkrieg in Umlauf bringen.

Mit der massenhaften, sofortigen Verbreitung von AI-Slops wächst die Sorge um unser Geschichtsbewusstsein – wie wir Geschichte sehen und welche Lehren wir daraus ziehen. Viele KI-Inhalte wirken wie echte Zeitzeugenschaft oder gründlich recherchierte Berichte, sind es aber nicht. Die Fähigkeit, Fakes von authentischen Quellen zu unterscheiden, ist deshalb dringender denn je. Wem etwas daran liegt, dass wir auch zukünftig gesellschaftlich von einem gemeinsamen, verlässlichen Faktenverständnis ausgehen, der sollte bewusst seriöse Aufklärungsangebote, Historiker und ähnliche Initiativen unterstützen – online wie offline.

Zum Thema:

Artikelbild: Screenshots facebook.com